01 Dic I deepfake sono diventati un’arma

Sono sempre più realistici. E sempre più in grado di confondere gli utenti online, alimentando la disinformazione. Uno strumento utilizzato per destabilizzare la società, come racconta questa inchiesta

Tratto da Wired, articolo di Vittoria Torsello, Cristina Gironès, Giovana Farìa

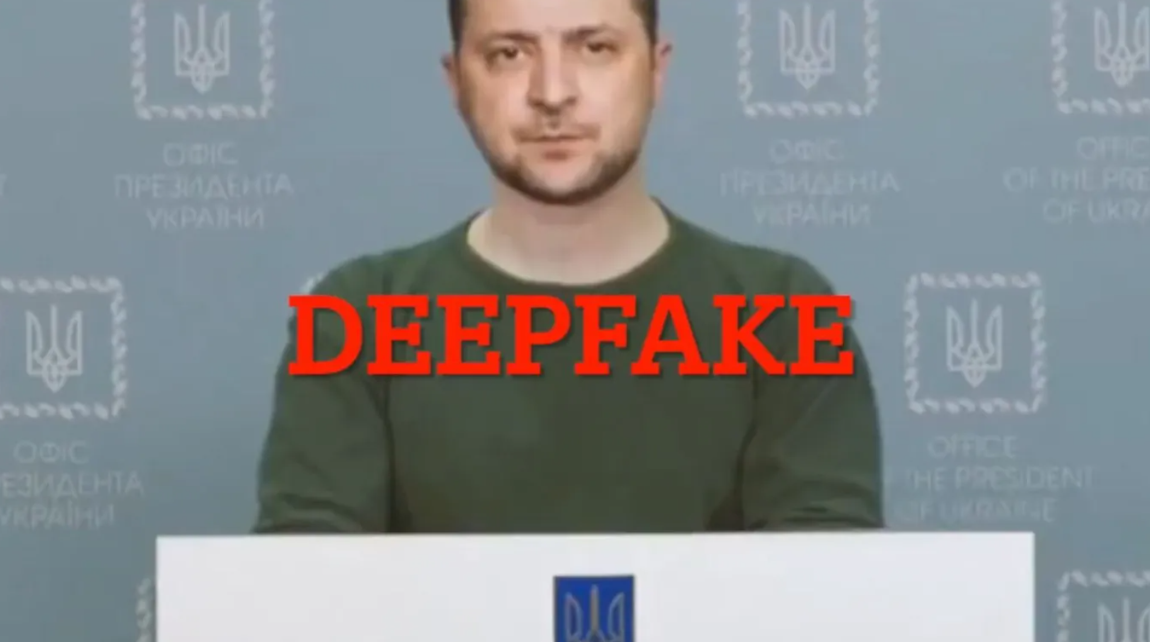

“Non c’è bisogno di morire in questa guerra. Vi consiglio di vivere,” intimava la voce seria del presidente dell’Ucraina Volodymyr Zelensky in uno dei video diventato virale a marzo 2022, poco dopo l’invasione della Russia, seguito da un altro del presidente russo Vladimir Putin, che parlava di una resa pacifica. Pur essendo di bassa qualità, i filmati sono riusciti a diffondersi velocemente, creando confusione e con l’obiettivo finale di trasmettere una narrazione distorta.

Nell’universo digitale, dove i confini tra realtà e finzione sono sempre più labili, è emerso un ulteriore mezzo che mette in discussione la realtà proiettata sui nostri schermi: i deepfake. Si tratta di montaggi iperrealistici che imitano l’aspetto o la voce di una persona. Dall’inizio della guerra tra Russia e Ucraina, il loro uso è stato un’arma di conflitto, infiltrandosi in ogni angolo dei social network. Nonostante le reazioni quasi immediate e il debunking che ne è seguito, la loro circolazione è stata più efficace in determinati casi.

La corsa dei deepfake

“Siamo creature molto visive, ciò che vediamo influenza ciò che pensiamo, percepiamo e crediamo – sostiene Victor Madeira, giornalista ed esperto di controspionaggio russo e disinformazione -. I deepfake rappresentano solo l’ultima arma progettata per confondere, sopraffare e, alla fine, paralizzare la presa di decisioni occidentale e la nostra volontà di reagire”. Mentre l’obiettivo è minare la fiducia nell’informazione, nei media e nella democrazia, il potere derivante da questa manipolazione attrae le piattaforme online. Sebbene queste ultime non siano legalmente obbligate a monitorare, individuare e rimuovere i deepfake dannosi, è nel loro interesse adottare politiche proattive per implementare tali strumenti e dare priorità alla protezione degli utenti.

Tuttavia, non sempre le necessità coincidono con gli interessi. “In quanto aziende, sono impegnate in una massiccia competizione per espandersi verso nuovi mercati, anche quando non hanno l’infrastruttura necessaria per proteggere effettivamente gli utenti”, sostiene Luca Nicotra, campaign director di Avaaz, ong specializzata nell’indagine della disinformazione online. Guadagnare con questo tipo di disinformazione, ricevendo feedback positivi, diventa dunque più vantaggioso, piuttosto che creare gli strumenti per impedirne la diffusione e salvaguardare gli utenti. E aggiunge: “Qualunque cosa accada con Facebook, Telegram, Instagram e altre piattaforme, è necessaria una revisione finale da parte di personale addestrato, ma questo comporta dei costi”.

Creare un deepfake

Gli sviluppi dell’intelligenza artificiale generativa hanno sollevato preoccupazioni sulla capacità della tecnologia di creare e diffondere disinformazione su una scala senza precedenti. “Si arriva a un punto in cui diventa molto difficile per le persone capire se l’immagine ricevuta sul loro telefono è autentica o meno“, sostiene Cristian Vaccari, professore di comunicazione politica presso la Loughborough University ed esperto in disinformazione. I contenuti prodotti inizialmente con pochi e semplici mezzi possono sembrare di scarsa qualità, ma, attraverso modifiche necessarie, possono diventare credibili. Un esempio recente coinvolge la presunta critica della moglie del presidente americano Joe Biden riguardo alla gestione della crisi in Medio Oriente.

“Gli strumenti esistono già per produrre deepfake anche solo con un prompt di testo – avverte Jutta Jahnel, ricercatrice ed esperta in intelligenza artificiale presso il Karlsruhe Institute of Technology -. Chiunque può crearli, questo è un fenomeno recente. Si tratta di un rischio sistemico complesso per l’intera società”. Un rischio sistemico di cui è già diventato difficile delineare i confini. Secondo l’ultimo rapporto del centro studi Freedom House, almeno 47 governi hanno utilizzato commentatori pro-governo per manipolare discussioni online a loro favore, raddoppiando il numero rispetto a un decennio fa. Per quanto riguarda l’uso dell’AI, “nel corso dell’ultimo anno è stata utilizzata in almeno 16 paesi per seminare dubbi, denigrare gli oppositori o influenzare il dibattito pubblico”.

Secondo gli esperti, la situazione sta peggiorando, e non è facile individuare i responsabili in un ambiente saturo di disinformazione causato dalla guerra. “Il conflitto tra Russia e Ucraina sta causando una maggiore polarizzazione e una maggiore motivazione a inquinare l’ambiente informativo“, sostiene Erika Magonara, esperta di Enisa, l’agenzia europea della cybersecurity. Attraverso l’analisi di vari canali Telegram, è emerso che i profili coinvolti nella diffusione di tali contenuti presentano caratteristiche specifiche. “C’è una sorta di circolo vizioso – spiega Vaccari -. Le persone che hanno meno fiducia nelle notizie, nelle organizzazioni informative e nelle istituzioni politiche diventano disilluse e si affidano ai social media o a determinati circoli, seguendo un approccio del tipo ‘fai la tua ricerca’ per contrastare le informazioni“. Il problema coinvolge non solo i creatori, ma anche i diffusori.

Inquinare la politica

“La disinformazione online, soprattutto durante i periodi elettorali e legata a narrazioni pro-Cremlino, rimane una preoccupazione costante”, riportano le prime righe di Freedom House nella sezione dedicata all’Italia. Dall’inizio della guerra, la Russia ha lavorato su Facebook per diffondere la sua propaganda attraverso gruppi e account creati appositamente a tale scopo. L’analisi dei vari canali Telegram operanti in Italia e Spagna ha confermato questa tendenza, rivelando inclinazioni verso ideologie di estrema destra e sentimenti anti-establishment. Questi elementi hanno fornito terreno fertile per la propaganda pro-Cremlino. Tra le narrazioni più diffuse, si trovano teorie che negano il massacro di Bucha, sostengono l’esistenza di biolaboratori americani in Ucraina e promuovono la narrazione sulla denazificazione dell’Ucraina stessa.

Una tendenza diffusa è stata la creazione di deepfake per parodiare i protagonisti politici della guerra, provocando un danno diffamatorio personale come principale conseguenza. Questo effetto è stato confermato da uno studio recente condotto dal Lero Research Centre presso l’University College Cork su Twitter, nel quale si afferma che “gli individui tendevano a trascurare o addirittura a incoraggiare i danni causati dai deepfake diffamatori quando erano diretti contro rivali politici”.

“Che cos’è un deepfake? Fate un piccolo esercizio e provate ad osservare i vari personaggi politici italiani, come Meloni, Salvini, Conte, Draghi e altri. Vi sembrano uguali o sono un po’ cambiati? Da quanto tempo [loro] utilizzano i deepfake?” Si legge questo messaggio su una delle chat Telegram analizzate. Mirare alla realtà come se fosse un deepfake ha conseguenze negative sulla percezione della verità. Questo riflette un’altra diretta conseguenza della diffusione dei deepfake in un ambiente informativo già denso di manipolazioni, ciò che gli accademici definiscono il “liar’s dividend“, ovvero l’incertezza informativa nell’ambiente mediatico che ne distorce ulteriormente la realtà. Ne è un effetto la narrazione secondo la quale i media occidentali utilizzano l’AI per manipolare la percezione del pubblico, sostenendo, per esempio, che la Russia non stia attaccando aree residenziali civili.

La terza tendenza individuata è l’assenza di debunking su Telegram. La mattina del 16 marzo 2022 ha segnato uno dei primi casi in cui un deepfake politico è stato deliberatamente utilizzato per diffondere disinformazione in un contesto di conflitto, sottolineando l’impatto potenziale dei deepfake. In questo caso specifico, tali contenuti hanno alimentato credenze cospiratorie e generato uno scetticismo dannoso. Questo fenomeno sembra verificarsi più frequentemente in determinati Paesi.

Il caso di Spagna e Italia

Un ambiente digitale assediato dai deepfake è ulteriormente messo a rischio dalla mancanza di adeguate contromisure. È il caso di Spagna e Italia, dove “ci sono il doppio delle situazioni di disinformazione, ma risorse limitate per monitorare questo fenomeno“, sostiene Nicotra. Un rapporto del 2020 di Avaaz ha evidenziato questa tendenza, sottolineando come utenti di lingua italiana e spagnola possano essere maggiormente esposti alla disinformazione. “I social network individuano solo la metà dei post falsi perché hanno scarso incentivo a investire in altre lingue“. La maggior parte del debunking avviene, infatti, per la lingua inglese.

“In questo momento, è uno svantaggio competitivo per qualsiasi azienda smettere di fornire agli utenti disinformazione e contenuti polarizzati”, sostiene Nicotra. Telegram è una delle piattaforme in questo contesto. Inoltre, tra tutti i 27 paesi dell’Unione Europea, Italia e Spagna sono quelli in cui Telegram è maggiormente utilizzato. Il 27% e il 23% della popolazione, rispettivamente, utilizzano questa rete per ottenere informazioni, come riportato nell’ultimo sondaggio Eurobarometer sull’uso dei media.

Se si considerano questi dati in relazione alla disinformazione russa, emerge una realtà preoccupante che favorisce ulteriormente la diffusione di determinate narrazioni all’interno di queste bolle informative. Come spiega Madeira, la disinformazione russa è adattata a ciascun paese o regione, ma gli stati mediterranei, in particolare, hanno una reputazione di essere “morbidi” con la Russia e sono ancor più indulgenti per quanto riguarda le questioni di sicurezza in generale. All’interno di questa mancanza di trasparenza e controllo sulla disinformazione, l’Unione europea ha cercato di intervenire promuovendo diverse leggi sulla regolamentazione dei contenuti.

La risposta europea: cosa manca ancora da fare

Approvato dal Parlamento europeo all’inizio della scorsa estate e ora in fase finale di negoziato, l’AI Act è la legge più recente che si concentra sull’intelligenza artificiale. Una delle misure che include è l’etichettatura della disinformazione per contrastare l’efficacia e ostacolare la generazione di contenuti illeciti. “Introduce obblighi e requisiti graduati in base al livello di rischio, al fine di limitare gli impatti negativi sulla salute, sicurezza e diritti fondamentali” – spiega l’europarlamentare Brando Benifei, relatore del disegno di legge -. Ciò che sta cambiando, tuttavia, è il livello di responsabilità che le istituzioni dell’Ue stanno sempre più – e giustamente – ponendo sulle piattaforme che amplificano questi contenuti, specialmente quando il contenuto è politico“.

Si tratta dunque di stabilire il livello di responsabilità per ciò che avviene, non solo a livello istituzionale, ma anche da parte delle piattaforme interessate: “Se accetti i deepfake sulla tua piattaforma, sei responsabile di quel contenuto. Sei anche responsabile dei rischi strutturali perché agisci come amplificatore di questa disinformazione“, sostiene Dragos Tudorache, anch’egli europarlamentare e co-relatore della legge.

Per la prima volta si è assistito a propaganda e disinformazione deepfake che hanno cercato di influenzare una guerra. Nonostante la pubblicazione del Digital services act, che stabilisce le basi per controllare la disinformazione sui social media e l’approvazione dell’AI Act sull’intelligenza artificiale da parte del Parlamento europeo, “l’AI ha reso la disinformazione una tendenza, facilitando la creazione di contenuti falsi“, afferma Erika Magonara. Il deepfake stesso rappresenta una tecnica bellica progettata per alimentare determinati tipi di discorso e stereotipi facilmente condivisibili. In un conflitto che non mostra segni di cessazione, come sostiene Magonara, “il vero obiettivo è la società civile“.

Sorry, the comment form is closed at this time.